Masse critique et point de dilution dans les business models du web social

Beaucoup de projets web avec lesquels je travaille, cherchent à s’appuyer sur des effets de réseaux sociaux. La création de valeur de ces sites est essentiellement reliée aux nombres de clients utilisateurs qui vont trouver un intérêt à interagir entre eux à l’aide du site proposé. Pensez à des sites comme AirBnB : si trop peu de voyageurs sont inscrits, personne n’aura envie de proposer son canapé à la location. Inversement, sans canapés visibles, qui pourra être incité à voyager en utilisant le site ?

Vous l’avez compris le problème de la masse critique est donc aussi doublé d’un problème de poule et d’oeuf : non seulement il faut une population suffisante, mais il faut aussi qu’il y ait des offreurs et des demandeurs en proportion équilibrée. Plusieurs stratégies permettent d’atteindre ce résultat et j’aurais peut-être le courage d’en discuter dans un autre article.

Signalons au moins, que si le modèle est vraiment très asymétrique avec par exemple des offreurs rares et des demandeurs très nombreux, il est assez logique de rendre le service gratuit pour la population rare et payant pour celle nombreuse. Meetic ayant de ce point de vue montré le chemin il y a quelques années en rendant le service gratuit pour les filles et payant pour les garçons ; mais c’est finalement ce que font les agences immobilières depuis très longtemps. On parie alors sur le fait que le service (gratuit) sera assez bien réfléchi pour que les offreurs daignent s’y inscrire et que dès lors, ils entraîneront la population de demandeurs à leur suite (qui eux, paieront).

Dans ce type de scénario on réfléchit en réalité aux offreurs de la façon suivante :

- Ce sont des clients à qui l’on fait la promotion d’une valeur ajoutée spécifique de notre site (à définir très clairement) ;

- La monétisation de ce segment client est gratuit, mais ils nous rémunèrent en terme de visibilité et en création de «stock» (ils nous amènent un potentiel de transaction qui sera notre offre pour les clients payants) ;

- Si le site est gratuit pour eux, ils ont néanmoins un coût d’acquisition représenté par les frais engagés pour les contacter, les séduire et les amener à maintenir leur présence sur le site.

Ce dernier point est généralement très mal maîtrisé par les startups. Il est néanmoins fondamental et explique par exemple, pourquoi Instagram a été une bonne affaire pour Facebook.

Sans partir plus loin dans les stratégies de création de masse critique, il me parait intéressant de discuter avec vous de leur pertinence réelle. En effet, le bon sens commun nous laisse dire qu’au plus vite la masse critique est obtenue, au mieux c’est. Je n’ai rien à dire, si le site est prêt et que la capacité à monter en charge est là, c’est bien le cas. Mais le raisonnement corollaire va être ensuite de dire : au plus cette masse grossit, au mieux cela va être.

Et ici apparait un piège létal qui n’est jamais clairement évoqué…

Il est vrai dans une analyse de premier niveau, qu’au plus un réseau est important, au plus il crée des effets vertueux :

- Il devient de plus en plus stable, la perte inévitable de certains utilisateurs étant toujours compensée par le flux entrant ;

- De nouveaux concurrents sur votre segment auront de plus en plus de mal à capter un auditoire que vous avec déjà fidélisé ;

- Vous allez pouvoir segmenter l’offre de votre site pour répondre à des besoins particuliers de sous-groupes utilisateurs qui auront par eux-mêmes atteint une masse critique ;

- Vous amortissez de mieux en mieux vos coûts fixes en profitant de la flexibilité du web pour gérer vos coûts variables, etc.

Mais, une fois le cap de la masse critique dépassé et celui de la masse que je qualifie de «vertueuse» atteinte, vous risquez d’atteindre ce dont personne ne va vous parler : le point de dilution. Ce point de dilution est atteint quand vous avez tellement d’utilisateurs, qu’ils vont finir par vider de son sens votre réseau, parce qu’ils vont diluer la valeur ajoutée que vous cherchez à avoir.

Un exemple de point de dilution dépassé ou risquant de l’être est évident avec Twitter. Quelle est la pertinence de ce site (que j’utilise avec plaisir depuis assez longtemps) quand dans votre flux vous avez des centaines de personnes que vous ne connaissez pas (mais que vous suivez par politesse ou réflexe pavlovien), qui diffusent des informations inintéressantes et qui, quand il y a la moindre information réellement intéressante, vont finir par la diffuser en boucle pendant 24h au détriment de tout le reste ?

Finalement, trop de tweets tuent la valeur ajoutée de Twitter. Et pour cette raison (mais pour d’autres aussi, liées aux conditions d’utilisation opaques) vous allez voir fleurir dans les mois qui viennent des tentatives de reboot d’un autre Twitter.

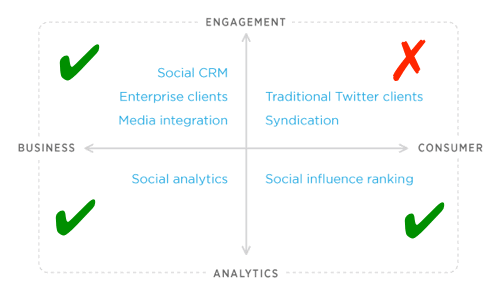

EDIT : L’actualité étant ce qu’elle est, certains d’entre vous auront noté que Twitter vient d’annoncer essentiellement qu’ils fermaient leur API à de futurs développeurs, pour recentrer leur activité en l’éloignant des clients twitter traditionnels qui atteignent le point de dilution, et en poussant vers des segments de marché qui eux ne sont pas en masse critique :

Des sites comme Linkedin sont face à la même problématique : quand vous avez plusieurs centaines de contacts professionnels sur le site (parce que Linkedin a eu besoin de faciliter les mises en contact à outrance pour atteindre une masse critique), quelle est la valeur résiduelle de ces mises en contact ? L’effet de réseau d’un ancien collègue de travail en poste dans une entreprise que vous cherchez à approcher, va être très différent de l’effet obtenu auprès du collègue du collègue de quelqu’un rencontré 15 min dans un salon professionnel !

Je pense que vous comprenez donc le besoin de vigilance sur ce point de dilution : à quel moment trop de monde va finir par discréditer ce que vous voulez faire ? Et à comment estimer cette notion de «trop» ? Ce n’est pas un problème de «riche», mais bien un élément de dimensionnement crucial qu’il faut percevoir dès la conception de votre service web.

De façon intéressante des sites comme Amazon ou Google sont par nature très robustes face à cet effet. À tel point que l’on pourrait même argumenter qu’ils n’ont pas de point de dilution. Mais ce serait je pense une erreur.

La robustesse d’Amazon tient surtout à sa capacité à gérer de la longue traîne et à sous-segmenter de façon réactive son colossal catalogue à votre profil. Vous ne naviguez jamais réellement dans Amazon de façon globale, mais dans le nuage (certes encore très vaste) des seuls produits qu’Amazon juge intéressant en fonction de votre profil établi par vos recherches. Il en est parfaitement de même pour Google.

La magie de ces deux sites est donc de gérer de façon dynamique et en temps réel tout effet possible de dilution. On ne vous noie pas dans des millions d’offres associées à votre demande, sous peine de vous voir fuir, mais on filtre et on épure ces offres, pour vous permettre de ne voir à chaque fois qu’une partie du réseau concerné.

Ce n’est donc pas un hasard que les algorithmes chargés de gérer ce que j’appelle le point de dilution, soient parmi les actifs les plus précieux et les plus secrets de ces sites.